La forma en la que el modelo de lenguaje de ChatGPT funciona está basada en la probabilidad de que determinadas palabras sean utilizadas para completar cada una de las frases generadas por el sistema de Inteligencia Artificial (IA), aunque la empresa desarrolladora de la herramienta, OpenAI, no ha dado mayores detalles sobre cómo está diseñado este mecanismo.

No obstante, ingenieros y desarrolladores de todo el mundo se han dedicado a analizar el funcionamiento de este chatbot para intentar recrearlo, para lo cual es necesario desentrañar con precisión la lógica que se encuentra por detrás de cada uno de los resultados. Y esto es precisamente lo que buscó hacer Santiago Ortiz, científico de datos y creador del proyecto Moebio Labs.

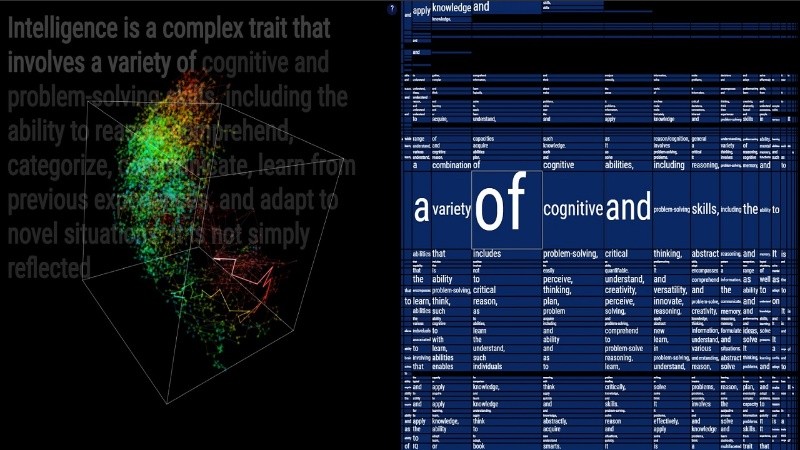

A través de uno de sus proyectos, titulado Mind, Ortiz representó de manera visual el método probabilístico basado en palabras (o tokens) con el que ChatGPT genera texto.

Este modelo grande de lenguaje (LLM) fue entrenado con un corpus masivo de textos de todo tipo y extensión, a partir del cual aprendió las probabilidades de distintas secuencias de palabras en función de la frecuencia de sus apariciones y el contexto.

Es decir, el modelo no comprende el lenguaje en el sentido humano, sino de forma matemática gracias a los patrones y secuencias de palabras.

Take a look into the mind of the machine! visit my new project here: https://t.co/Q8CIvwcsby

— Santiago Ortiz (@moebio) March 21, 2024

I repeated the same completion prompt "Intelligence is " hundreds of times and used this to peer into the statistical and semantic behavior of chatgpt pic.twitter.com/UUZsmOTAMb

Para su experimento, el científico de datos eligió la frase "La inteligencia es" como indicación para que el modelo comenzara a generar su respuesta, y la repitió cientos de veces "para observar el comportamiento estadístico y semántico de ChatGPT", según comentó en su cuenta de X.

Con los datos obtenidos a partir de sus pruebas, Ortiz construyó un sitio dividido en dos partes: a la izquierda de la pantalla se ven las respuestas generadas por el LLM; a la derecha, el usuario puede navegar entre todas las opciones de palabras que formaron parte del procesamiento del modelo durante la elaboración de esas respuestas.

Cómo es el proceso con el que ChatGPT genera sus respuestas

- Inicialización: el modelo de IA comienza a trabajar a partir del pompt (indicación en lenguaje natural) que introduce el usuario.

- Predicción de tokens: el modelo genera una secuencia de palabras y predice una distribución de probabilidad para la siguiente palabra.

- Muestreo: de esa manera se selecciona la siguiente palabra. La selección puede ser determinista (elegir la palabra más probable) o implicar alguna forma de aleatoriedad (para generar resultados más variados o creativos).

- Repetición: ese mismo proceso se repite tomando la secuencia extendida –es decir con la palabra recién agregada– como nueva entrada para cada paso, hasta que la respuesta encuentre un token de parada o bien alcance una longitud máxima.

Finalmente, se sigue con la fase de refinamiento para que el modelo continúe su entrenamiento y mejore los parámetros con los que asigna probabilidades a cada palabra, teniendo en cuenta las palabras anteriores y el contexto, para responder con cada vez más precisión.