A lo largo de la historia, delincuentes y estafadores han explotado al máximo la creatividad y los medios disponibles para encontrar formas ingeniosas de manipular a sus víctimas y despojarlas de su dinero. Apelando tanto a los trucos más simples como a los esquemas más elaborados, estos actores del engaño invariablemente han recurrido a la persuasión, la mentira y la explotación de la natural credulidad humana para lograr sus objetivos. Desde la venta de falsas reliquias religiosas durante la Edad Media, pasando por fraudes postales, hasta llegar a las estafas telefónicas y vía correo electrónico siglos después, la evolución de sus tácticas demuestra la constante adaptación de los métodos delictivos a las tecnologías de cada época.

Para estos criminales, el boom de la inteligencia artificial generativa es una de las mejores noticias de las últimas décadas, presentando una oportunidad inigualable para perfeccionar sus artimañas. Esta tecnología ofrece un abanico de posibilidades sin precedentes, permitiéndoles crear estafas cada vez más convincentes, sofisticadas y difíciles de detectar. Así, la misma herramienta que puede ser utilizada para crear personajes y escenarios en videojuegos o ayudar a un estudiante a prepararse para un examen, en manos de un delincuente inescrupuloso puede convertirse en una poderosa arma para el engaño y la manipulación.

Las estafas mediante deepfakes son una de las principales preocupaciones en materia de ciberseguridad, representando una amenaza real para millones de personas, pero especialmente para objetivos de alto valor, como políticos, ejecutivos y celebridades. Estos vídeos falsos pero de apariencia auténtica, han sido utilizados para cometer diferentes tipos de fraudes financieros, muchas veces millonarios, así como suplantaciones de identidad y engaños a gran escala.

Un claro ejemplo de esto ocurrió a comienzos de este año, cuando se viralizó en redes sociales como TikTok y Facebook una serie de videos en los que, aparentemente, Taylor Swift regalaba a sus seguidores utensilios de cocina de la marca francesa Le Creuset. En estos vídeos, la estrella del pop se dirigía directamente a las “Swifties” (como se conoce a sus fans), alentándolas a aprovechar la oferta gratuita a cambio de hacerse cargo solo de los gastos de envío: apenas $9,96 a pagarse con tarjeta de crédito o débito.

Los incautos usuarios que hicieron clic en los enlaces de los vídeos fueron redirigidos a versiones falsas de la web de Le Creuset, donde ingenuamente completaron formularios con su información personal y financiera para cubrir el supuesto envío. Los ciberdelincuentes detrás de este engaño con deepfakes no solo obtuvieron los datos de miles de tarjetas, sino que también cobraron los falsos costos de transporte repetidas veces.

En febrero de este año, también se dio un incidente digno de la saga de películas “Misión Imposible”, cuando el gerente financiero de una multinacional cayó víctima de un sofisticado fraude, al ser engañado para participar en una videoconferencia con los que creía que eran varios miembros del personal de la empresa. Sin embargo, todos ellos eran deepfakes, incluído el estafador principal, quien haciéndose pasar por el CEO de la compañía, solicitó al responsable de finanzas que realice una transferencia por más de 25 millones de dólares. El trabajador nunca sospechó nada, ya que los participantes de la reunión se veían y sonaban como colegas reconocibles.

Gracias a la evolución de la tecnología, los deepfakes han mejorado drásticamente, dando lugar a representaciones de personas que se ven y escuchan con una precisión extremadamente preocupante. Ya no se trata solo de imitaciones de famosos intentando engañarte, ahora puede ser tu amigo o algún pariente cercano quien te llama por teléfono para pedirte dinero porque, supuestamente, está atravesando una situación personal complicada.

Las estafas de clonación de voz se han convertido en una de las amenazas más infames en el panorama actual del cibercrimen. Esta práctica implica replicar el tono de una persona conocida, generalmente un ser querido a quien reconocerías inmediatamente al escuchar hablar. El impostor, con una angustia palpable, solicita tu ayuda porque sufrió un robo o un accidente. Los estafadores solo necesitan unos segundos de audio, obtenidos fácilmente de redes sociales o llamados telefónicos previos, para reproducir el timbre vocal de la víctima con una exactitud sorprendente. No intente detectar una voz falsa por teléfono, no lo logrará.

Los delincuentes también encontraron en la IA generativa una herramienta formidable para perfeccionarse en el arte del engaño y llevarlo a niveles inquietantes de sofisticación, creando identidades completamente ficticias en redes sociales y aplicaciones de citas. Dotadas de elaboradas biografías e intereses cuidadosamente seleccionados, estos humanos sintéticos son utilizados para tejer complejas tramas de farsas y mentiras, que van desde fraudes financieros a estafas románticas.

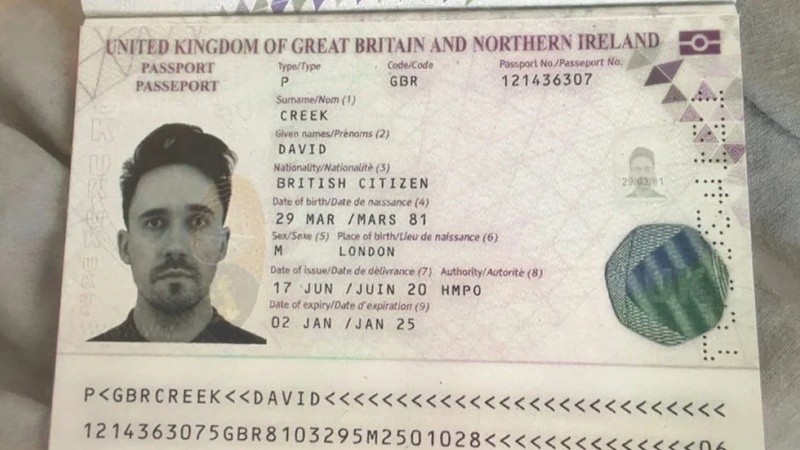

Sus redes de contactos, también artificiales, incluyen perfiles falsos minuciosamente preparados de supuestos colegas y amigos, creando un contexto coherente y altamente convincente que refuerza la credibilidad de la trampa. Ya no se trata simplemente de fotos robadas o retocadas, sino de identidades completas diseñadas algorítmicamente para atraer a víctimas específicas, basándose en sus preferencias y vulnerabilidades psicológicas.

La semana pasada, la Policía Nacional de España advirtió sobre una nueva modalidad de estafa que tiene como protagonista a la inteligencia artificial. Los delincuentes, aprovechando el poder de las herramientas de IA generativa, crean imágenes de viviendas lujosas que no existen y las publican para la venta o alquiler en portales especializados. Estos inmuebles se ofrecen a un precio más bajo de lo que indica el mercado atrayendo el interés de innumerables víctimas.

Aquellos interesados en comprar o alquilar la propiedad son dirigidos a una plataforma de mensajería para continuar con las negociaciones, y son persuadidos para realizar pagos por adelantado, ya sea en concepto de alquiler o de reserva. Una vez realizadas las transferencias, los estafadores cortan todo contacto, dejando a los damnificados sin vivienda y sin dinero.

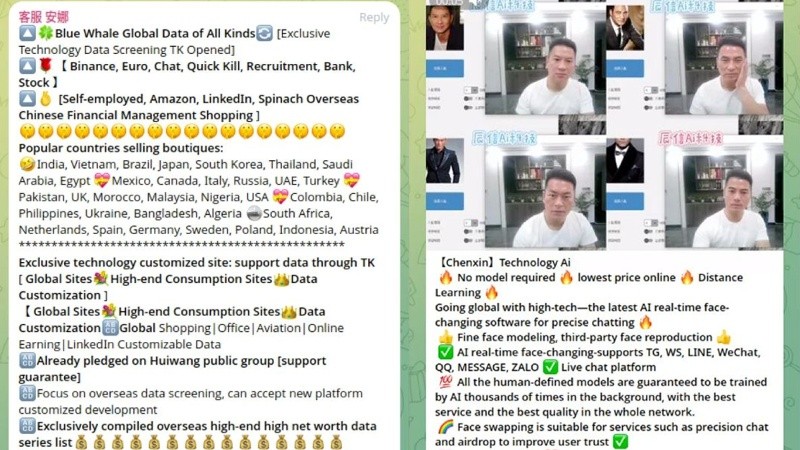

La explosión de la IA generativa produjo un efecto secundario inesperado: la democratización del fraude. Ahora es más fácil que nunca que cualquier persona sin un piso de conocimientos técnicos mínimos pueda participar en estas actividades. Basta con pasar el tiempo suficiente en foros especializados, grupos de Telegram o en la dark web para encontrar tutoriales, herramientas y la tecnología necesaria para llevar adelante estos engaños. Es una tendencia conocida como fraude como servicio (FaaS, por sus siglas en inglés), donde estafadores experimentados venden sus conocimientos y técnicas a principiantes inexpertos.

Este modelo de negocio ilícito ha reducido significativamente la barrera de entrada para los ciberdelincuentes novatos. Los proveedores de FaaS ofrecen una amplia gama de servicios, desde kits de phishing prefabricados hasta sistemas completos de clonación de voz, pasando por webs falsas para estafas con criptomonedas y software de cambio de rostro mediante IA para numerosas plataformas de chat en vivo y aplicaciones de mensajería. Incluso proporcionan soporte técnico y actualizaciones regulares, tal como hacen las empresas de software legítimas.

Los ciberdelincuentes también han desarrollado sus propias herramientas de IA maliciosas, como WormGPT, una suerte de ChatGPT pero diseñada específicamente para actividades delictivas. WormGPT es capaz de generar correos electrónicos de phishing adaptados a cada víctima individual a partir del análisis de grandes cantidades de datos personales filtrados, permitiendo ataques altamente individualizados y extremadamente convincentes, aumentando la probabilidad de éxito.

Entre sus diversas funciones, también puede escribir código malicioso, como virus, ransomware y troyanos, para infectar sistemas y robar sus datos. Esta herramienta no solo automatiza los procesos de creación de amenazas, sino que los hace más sofisticados y difíciles de detectar, ya que los algoritmos de IA pueden modificar continuamente la secuencia de comandos para evadir firewalls y software antivirus.

Hasta hace poco tiempo, estos ataques y estafas eran costosos y requerían mucho tiempo, por lo que se limitaban a objetivos de alto valor. Sin embargo, la evolución de la IA modificó radicalmente este panorama y ahora los ciberdelincuentes, aun sin experiencia y formación, pueden escalar sus operaciones a niveles inconcebibles hace pocos meses. Esta democratización del fraude nos obliga como usuarios a cuestionar la autenticidad de cada interacción online, desde correos electrónicos, perfiles de redes sociales y audios de WhatsApp hasta ofertas demasiado buenas para ser verdad. En un mundo digital donde las apariencias engañan y los bits pueden mentir, la paranoia ya no es una enfermedad, sino una herramienta de supervivencia.