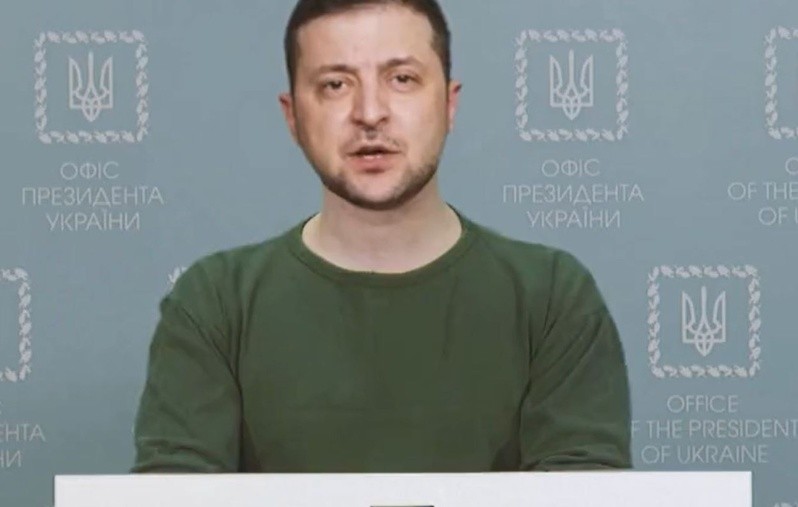

En marzo de este año, apenas unas semanas después de comenzada la invasión de Rusia a Ucrania, el canal de noticias Ucrania-24 publicaba -tras un ataque informático- un video del presidente Zelenksi pidiendo la rendición de sus tropas. El clip, una tosca manipulación de baja calidad y de poco más de un minuto de duración, igualmente viralizó a través de las principales redes sociales, de donde fue rápidamente eliminado. Independientemente de lo poco convincente del producto, se trataba del primer uso registrado de un deepfake creado intencionalmente como arma de desinformación.

El Diccionario de Oxford define a los deepfakes como “un vídeo de una persona en el que se ha alterado digitalmente su rostro o su cuerpo para que parezca otra persona, normalmente utilizado con malicia o para difundir información falsa”. El resultado es un archivo de video en el que los rasgos faciales de un sujeto de origen se trasladan a un sujeto de destino, pero manteniendo las expresiones y movimientos de este último. El término deepfake (ultrafalso) es una combinación de deep learning, una técnica de inteligencia artificial y la palabra fake, falso o falsificación.

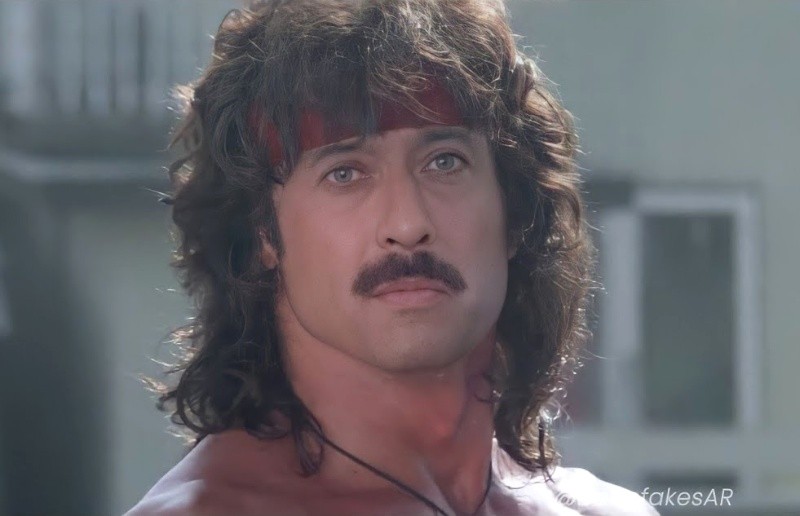

“Hay muchos tipos de deepfakes, están los más básicos y los más avanzados y detallados”, cuenta Sebastian Vaggi, el artista digital detrás del canal de YouTube DeepfakesAR. Entre sus trabajos, destaca el reciente deepfake de Messi cantando en el videoclip de Luis Miguel “Tengo todo excepto a ti”, parte de una campaña mundialista de un canal de deportes y Guillermo Francella haciendo de Rambo, entre otros.

“Si vamos a los básicos, simplemente con una imagen y el software adecuado podemos hacer un deepfake”, dice Sebastián. “En esos deepfakes, al tener tan poco material, se obtienen resultados menos parecidos a la persona que queremos poner y en baja resolución, pero se gana en tiempo ya que en minutos podes tener los resultados”, explica. No obstante, para obtener efectos más creíbles se necesita mucho más tiempo de trabajo, tanto humano como computacional. “En los deepfakes avanzados se utilizan entre mil a diez mil imágenes de la cara de la persona que se quiere colocar en el video, y dependiendo de la resolución y calidad que se busque, el proceso puede tardar entre una a cuatro semanas”, específica.

El software necesario para generar deepfakes es gratuito y fácil de descargar, aunque eso no significa que sea un trabajo sencillo. El procedimiento para crear deepfakes verosímiles no solo demanda hardware potente, también necesita de una cantidad de conocimientos de los más diversos: desde el funcionamiento de redes neuronales a edición de video y postproducción. “Para los deepfakes más avanzados se requiere de placas de video con una gran cantidad de memoria, cuanta más memoria, más resolución se puede alcanzar. Lo más común en el mundo audiovisual es usar placas de más de 24 GB de RAM o directamente contratar GPU [ndr: unidades de procesamiento gráfico] en servicios en la nube”, precisa Vaggi.

La tecnología que hace posible los deepfakes puede rastrearse al año 1997 con el programa Video Rewrite. Este software, pensado para el doblaje de películas, podía sincronizar los movimientos labiales de los actores con una nueva pista de audio utilizando inteligencia artificial, creando un nuevo video en el que los personajes decían algo diferente a la grabación original. Sin embargo la verdadera revolución comenzó en 2017, cuando un usuario con el seudónimo “DeepFake” publicó en un foro de Reddit vídeos pornográficos protagonizados por actrices de Hollywood como Emma Watson, Katy Perry, Scarlett Johansson y la cantante Taylor Swift. El usuario había entrenado algoritmos de inteligencia artificial utilizando películas para adultos y a las mencionadas actrices. Inmediatamente, decenas de miles de personas comenzaron a hacer los mismos vídeos y compartirlos, evidenciando importantes consecuencias para la privacidad e identidad.

Como era de esperarse, los ciberdelincuentes inmediatamente se apropiaron de estas herramientas para innovar en el delito. En enero de 2020, estafadores clonaron la voz del director de una importante empresa y convencieron al gerente de un banco de los Emiratos Árabes Unidos para autorizar una transferencia de 35 millones de dólares. El ejecutivo y el gerente ya habían conversado en el pasado, por lo que éste identificó la voz como auténtica y aprobó la operación. Los 35 millones de dólares terminaron en manos de los delincuentes.

Este es el segundo caso de fraude realizado mediante la tecnología de clonación de voz. El primero sucedió en 2019 en el Reino Unido, cuando el gerente de una empresa energética recibió un llamado de quién parecía ser el director general de la casa matriz, con sede en Alemania, pidiendo una transferencia urgente de 220.000 euros. El empleado británico, acatando la orden de su supuesto jefe, la realizó inmediatamente.

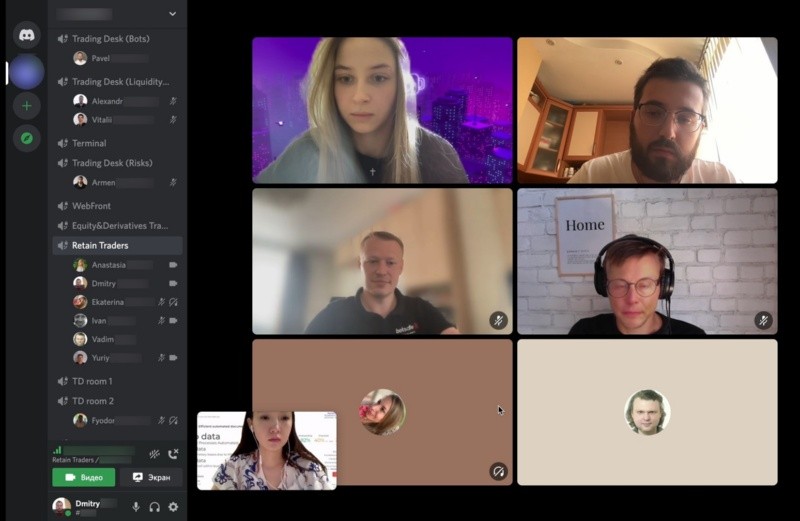

Ahora, los ciberdelincuentes están aprovechando los deepfakes para presentarse en entrevistas laborales remotas para puestos en empresas tecnológicas. De esta manera, buscan acceder a contraseñas, información sensible y sistemas informáticos con el fin de instalar software malicioso para llevar adelante ataques o para acceder a bases de datos e información personal y financiera de clientes y la empresa. Este tipo de estafa se está volviendo tan común que el pasado 28 de junio el FBI emitió una alerta para advertir sobre el aumento de este tipo de denuncias.

Para Sebastián Vaggi, así como en el pasado sucedió lo mismo con los fotomontajes, el mal uso de este recurso es inevitable. “No hay forma de frenar este tipo de tecnologías, creo que hay que encontrar la mejor manera de adaptarse. Actualmente no son perfectos y se pueden detectar pero creo que en el mediano plazo ya va a ser imposible”, agrega. “Hoy en día se pueden detectar por inconsistencias en la iluminación o los reflejos en los ojos, por ejemplo. También al pasar determinados objetos por delante de las caras, suelen generar un movimiento antinatural, pero son cosas que van evolucionando muy rápido y en cuestión de meses se corrigen y se hacen más difíciles de detectar”, indica el artista digital.

Como si se tratara de un juego del gato y el ratón perpetuo, a medida que avanz. la tecnología para generar deepfakes más convincentes, también lo hacen los métodos de detección. Aún así, el realismo de los deepfakes del futuro será imposible de descubrir para el ojo humano, y la industria del software tendrá que adaptarse a los futuros métodos y algoritmos de una tecnología que, sin duda alguna, será una poderosa herramienta para el fraude y la desinformación. Esto es solo la punta del iceberg.